Deux assureurs déploient la même technologie d’IA pour automatiser leur gestion de sinistres. Même algorithme, même budget, même ambition.

Six mois plus tard, le premier affiche 20% d’adoption et une satisfaction client en baisse. Le second atteint 60% d’adoption avec un NPS en progression.

Qu’est-ce qui a changé ? Pas la technologie. Le design du parcours.

Cette différence n’est pas anecdotique. Une étude Insurance Nexus révèle que seuls 22% des assureurs jugent leurs processus de gestion de sinistres « à la pointe », tandis que 87% des assurés (selon Bain & Company) considèrent leur « expérience sinistre » comme déterminante pour rester fidèles à leur assureur. Dans un marché où acquérir un nouveau client coûte cinq fois plus cher que fidéliser un client existant, cette équation change tout.

Pourtant, beaucoup d’assureurs continuent d’automatiser en se concentrant uniquement sur l’efficacité opérationnelle, négligeant trois dimensions pourtant décisives pour le succès : le cadre légal, le comportement humain, et la transformation des métiers.

Cet article explore ces trois dimensions et montre comment les organisations qui réussissent ne se demandent pas « comment automatiser plus », mais « comment automatiser mieux ».

Beaucoup d’organisations hésitent à automatiser par peur de sanctions. Cette peur est légitime, mais elle ne doit pas paralyser. Le cadre européen est strict, mais il est praticable.

Le règlement européen sur l’intelligence artificielle, entré en vigueur le 1er août 2024, classe les systèmes d’IA selon leur niveau de risque. Pour l’assurance, la situation est nette : l’évaluation des risques et la tarification en assurance-vie et santé sont classées comme systèmes à haut risque.

Cette classification impose trois obligations majeures : transparence totale sur le fonctionnement de l’algorithme, traçabilité de chaque décision, et analyse d’impact sur les droits fondamentaux.

Les sanctions ? Jusqu’à 30 millions d’euros ou 6% du chiffre d’affaires mondial (selon le règlement européen AI Act), selon le montant le plus élevé.

Mais la gestion courante des sinistres n’est pas systématiquement classée « haut risque ». Un bris de glace traité automatiquement avec possibilité de recours ? Acceptable. Un refus de couverture entièrement automatisé sans intervention humaine possible ? Problématique.

Depuis 2018, le RGPD pose un principe fondamental dans son article 22 : toute personne a le droit de ne pas faire l’objet d’une décision fondée exclusivement sur un traitement automatisé produisant des effets juridiques significatifs, sans intervention humaine possible.

Trois exceptions existent : consentement explicite, nécessité contractuelle, ou autorisation légale. Dans tous les cas, l’assuré doit pouvoir obtenir une explication de la décision, la contester, et demander une révision humaine.

La solution pragmatique qui émerge dans le secteur ? Segmenter les dossiers selon leur complexité et leur enjeu, en appliquant le principe du « Human-in-the-loop » (supervision humaine dans la boucle décisionnelle).

70-80% des cas : automatisation supervisée

Bris de glace, assistance dépannage standard, demandes d’information courantes. L’IA traite de bout en bout. Un algorithme surveille les anomalies et remonte les cas douteux à un humain.

Vous pouvez : Automatiser complètement ces sinistres simples (généralement < 500€), à condition de maintenir une possibilité de recours et d’explication.

15-20% des cas : collaboration IA-humain

Sinistres avec responsabilité partagée, montants élevés, circonstances inhabituelles. L’IA collecte les informations, effectue une première analyse, suggère une évaluation. Mais c’est un gestionnaire qui prend la décision finale.

Vous pouvez : Utiliser l’IA pour pré-analyser et préparer les dossiers complexes, avec décision humaine obligatoire.

5-10% des cas : intervention humaine exclusive

Situations de vulnérabilité (personnes âgées isolées, handicap), litiges contentieux, sinistres graves avec préjudice corporel important. Ces dossiers requièrent empathie et jugement nuancé dès le départ.

Vous devez : Garantir un accès direct à un humain pour ces situations sensibles.

Le cadre légal ne bloque pas l’automatisation. Il en fixe les limites. Trois règles à respecter absolument :

Cette architecture n’est pas qu’une contrainte. C’est aussi une garantie de qualité : les dossiers complexes méritent un œil humain, les dossiers simples méritent une résolution immédiate.

Le cadre réglementaire européen (AI Act + RGPD) n’interdit pas l’automatisation, il la balise. La clé : segmenter les dossiers par niveau de complexité, maintenir toujours une possibilité d’intervention humaine, et garantir transparence et explicabilité. Le modèle « Human-in-the-loop » concilie conformité et efficacité.

La conformité légale fixe le cadre. Mais entre « ce qui est permis » et « ce qui fonctionne vraiment », il y a un monde. Un monde que l’économie comportementale nous aide à comprendre.

Prenons deux assureurs qui automatisent leur service d’assistance en cas de sinistre auto.

L’assureur A présente son parcours ainsi :

« Vous êtes victime d’un sinistre auto. Souhaitez-vous être assisté par notre chatbot pour accélérer votre prise en charge ? [Oui] [Non, je préfère parler à un conseiller] »

L’assureur B présente le même parcours différemment :

« Votre assistant digital va traiter votre demande immédiatement. Vous pouvez à tout moment parler à un conseiller en cliquant ici. »

Même technologie. Même capacité de traitement. Mais résultats radicalement différents : 20% d’adoption pour l’assureur A, 60% pour l’assureur B.

Pourquoi ? L’effet de défaut.

Une méta-analyse de recherches en économie comportementale (Johnson & Goldstein, 2003) montre que les individus ont 27% de probabilité supplémentaire de choisir l’option présentée comme « par défaut » — même quand ils sont libres de changer.

Ce n’est pas de la manipulation. C’est de la conception réfléchie. Dans un moment de stress (un sinistre), présenter l’option la plus rapide comme choix par défaut simplifie la décision. L’assuré garde toujours le contrôle, mais il n’est plus paralysé par l’indécision.

Et voici le paradoxe : les utilisateurs placés en opt-out (comme l’assureur B) se sentent plus autonomes que ceux placés en opt-in (comme l’assureur A). Pourquoi ? Parce qu’ils n’ont pas eu à « justifier » leur choix dès le départ. Ils ont simplement avancé, sachant qu’ils peuvent sortir à tout moment.

Fort de ces constats, voici quatre principes qui font la différence entre automatisation subie et automatisation adoptée.

Règle 1 : Présenter l’automatisation comme le chemin naturel, pas comme une option à justifier

❌ Mauvais design :

« Voulez-vous utiliser notre assistant automatique ou préférez-vous parler à un conseiller ? »

✅ Bon design :

« Votre demande est en cours de traitement. À tout moment, vous pouvez parler à un conseiller. »

La différence ? La première formulation force un choix. La seconde offre une sécurité.

Règle 2 : Rendre la sortie facile et visible, pas honteuse

Le bouton « Parler à un conseiller » doit être :

Une étude Forrester révèle que les utilisateurs sont 2,5 fois plus enclins à utiliser un système automatisé quand ils voient clairement comment en sortir.

Règle 3 : Expliquer sans noyer

L’assuré ne veut pas un cours sur l’IA. Il veut savoir trois choses :

Gardez les explications courtes, concrètes, rassurantes.

❌ « Notre système d’intelligence artificielle analyse votre dossier en utilisant des algorithmes de machine learning conformes aux normes RGPD… »

✅ « Nous analysons votre dossier. Réponse sous 2 minutes. Vous pouvez parler à un conseiller ici. »

Règle 4 : Reconnaître quand l’humain est nécessaire

Et c’est ici qu’intervient un concept fascinant de la recherche en IA : le paradoxe de Moravec.

En 1988, le chercheur Hans Moravec a formulé une observation contre-intuitive : ce qui est difficile pour l’humain est facile pour l’IA, et inversement.

Exemples concrets dans l’assurance :

L’IA excelle sur :

L’humain excelle sur :

Le problème de beaucoup d’automatisations ? Elles inversent cette logique. Elles envoient les cas « simples » (au sens technique) vers l’IA, sans se demander si ces cas sont « simples » au sens humain.

Un bris de glace ? Techniquement simple, émotionnellement neutre. Parfait pour l’automatisation.

Un sinistre auto avec blessure légère ? Techniquement simple aussi, mais émotionnellement chargé. Une personne choquée après un accident n’est peut-être pas prête à échanger avec un chatbot, même performant.

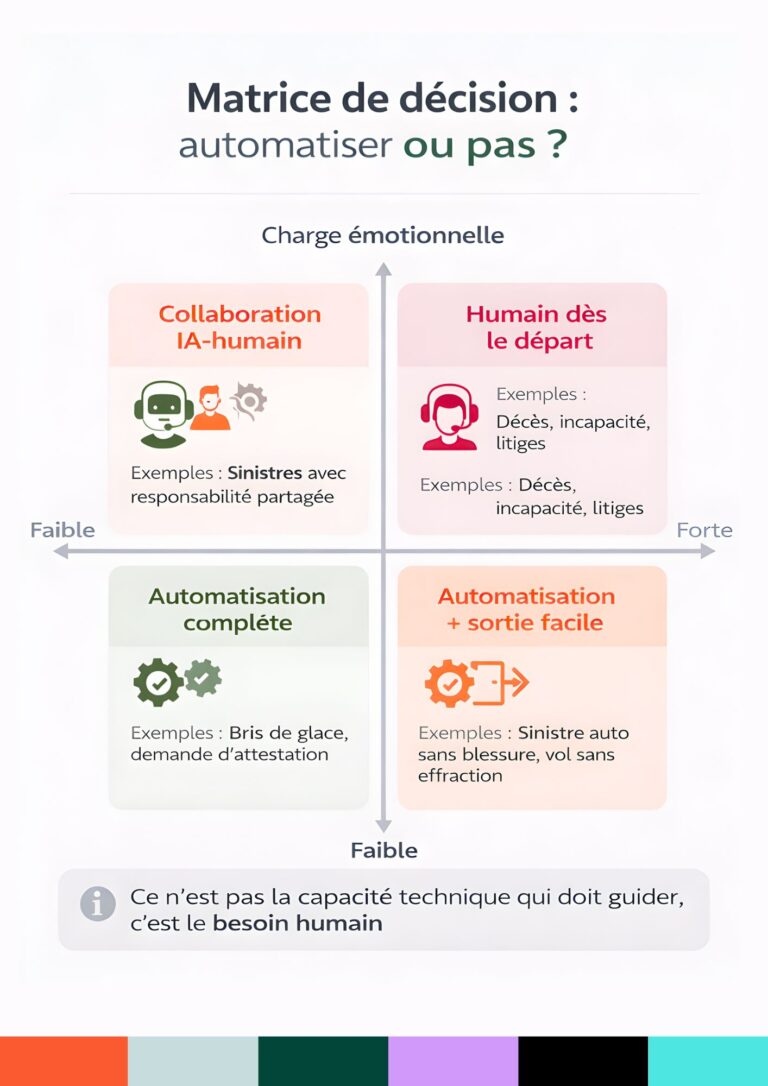

Les organisations qui réussissent ne demandent pas « Peut-on automatiser ce cas ? » mais « Ce cas mérite-t-il une intervention humaine dès le départ ?«

Elles croisent deux critères :

Cela donne une matrice simple :

| Faible charge émotionnelle | Forte charge émotionnelle | |

|---|---|---|

| Faible complexité | ✅ Automatisation complète | ⚠️ Automatisation + sortie facile |

| Forte complexité | ⚠️ Collaboration IA-humain | 🚫 Humain dès le départ |

Exemples :

Les chiffres du secteur donnent raison à cette approche :

L’automatisation réussie ne remplace pas l’humain. Elle le libère pour ce qu’il fait de mieux.

L’effet de défaut montre que deux parcours identiques peuvent donner des résultats très différents.

Pour bien réussir, quatre règles d’or :

Le paradoxe de Moravec nous rappelle que l’IA est très performante pour gérer la complexité technique, tandis que l’humain reste indispensable pour l’empathie et le jugement contextuel. Un bon design réussit à combiner ces deux forces.

Le cadre légal et le design comportemental sont essentiels. Mais ils ne suffisent pas. La troisième dimension, souvent sous-estimée, est la transformation des métiers qui accompagne l’automatisation.

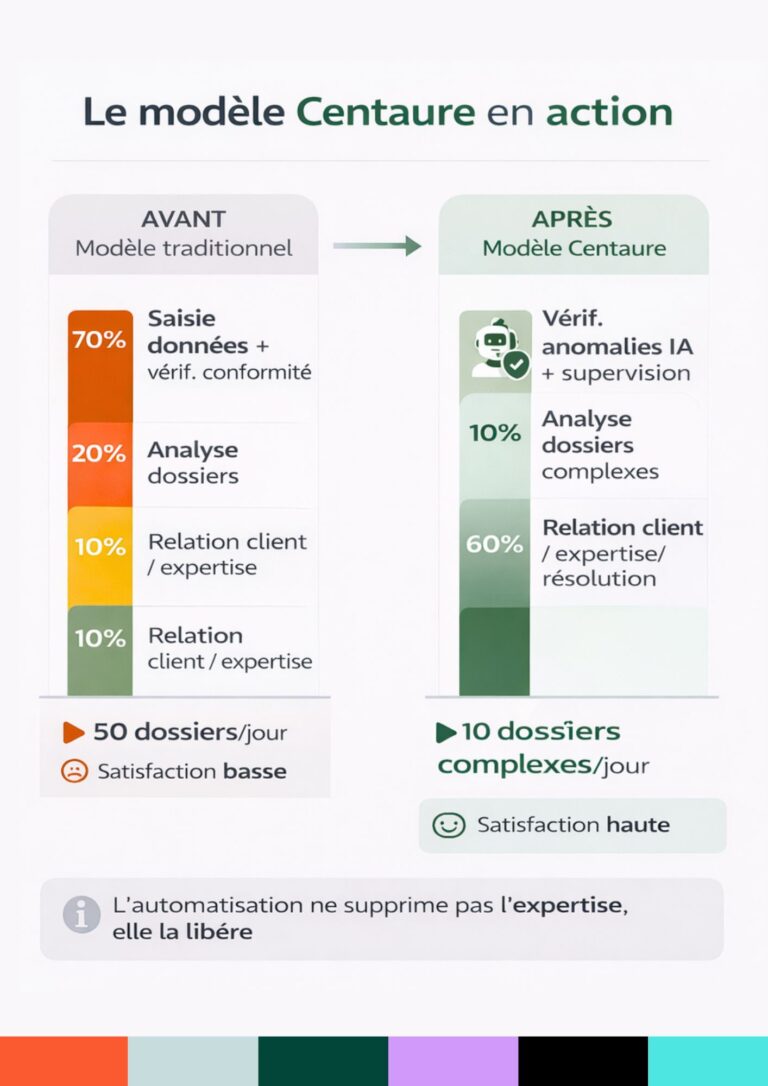

Aujourd’hui, un gestionnaire de sinistres passe en moyenne 70% de son temps sur des tâches administratives : saisie de données, vérification de conformité, demandes d’informations complémentaires, suivi de procédures standard.

Ce travail est nécessaire. Mais il n’est ni valorisant ni différenciant.

Pire : il génère ce que les spécialistes appellent le « brown-out » — cette perte de sens liée à l’exécution répétée de tâches perçues comme déconnectées de la finalité réelle du métier.

Les symptômes ? Fatigue chronique, cynisme, turnover élevé. Le coût ? Remplacer un gestionnaire expérimenté coûte souvent plus de 50% de son salaire annuel, sans compter la perte de connaissance métier et l’impact sur la qualité de service.

L’automatisation bien conçue offre une voie de sortie par le haut. Elle ne supprime pas les emplois : elle les transforme.

Le terme « modèle Centaure » vient du jeu d’échecs. En 1997, Deep Blue bat Kasparov. Fin de l’histoire ? Non. Début d’une nouvelle ère : le « Centaur Chess », où un humain assisté d’une IA bat à la fois l’humain seul ET l’IA seule.

Transposé à l’assurance, cela donne :

L’IA prend en charge (70-80% du volume) :

Le gestionnaire se concentre sur (20-30% du volume, mais 80% de la valeur) :

Le résultat ? Au lieu de traiter 50 dossiers simples par jour avec peu de satisfaction, le gestionnaire traite 10 dossiers complexes avec impact réel.

Quand cette transformation est bien menée, trois bénéfices apparaissent clairement :

1. Pour les assurés : rapidité + qualité

Les dossiers simples sont traités en quelques minutes au lieu de quelques jours. Les dossiers complexes bénéficient de l’attention d’un expert, pas d’un administratif débordé.

Résultat : selon Capgemini, 30% de réduction des délais de traitement en moyenne, avec une amélioration concomitante de la satisfaction client.

2. Pour les collaborateurs : sens retrouvé

Libérés des tâches répétitives, les gestionnaires redécouvrent le sens de leur métier. Ils ne sont plus des « traiteurs de formulaires », mais des conseillers, des négociateurs, des experts.

Les compétences valorisées changent : intelligence émotionnelle, expertise technique pointue, capacité d’analyse dans l’ambiguïté.

Plusieurs assureurs qui ont opéré cette transformation rapportent une baisse significative du turnover et une amélioration de l’attractivité des métiers auprès des jeunes talents.

3. Pour l’entreprise : efficacité + différenciation

L’automatisation réduit les coûts opérationnels (moins d’erreurs, moins de ressaisies, moins de temps perdu). Mais surtout, elle crée un avantage concurrentiel difficilement copiable : une expérience client supérieure.

N’importe qui peut acheter la même technologie. Mais bien la déployer — avec le bon design comportemental, la bonne segmentation, et la bonne transformation des métiers — c’est une autre histoire.

Si les bénéfices sont clairs, pourquoi autant de projets échouent-ils ? Trois erreurs reviennent systématiquement :

Erreur 1 : Croire que la technologie suffit

Déployer un chatbot sans repenser le parcours client, c’est comme acheter une voiture de course et rouler sur un chemin de terre. La technologie n’est qu’un outil. C’est le design du parcours qui fait la différence.

Erreur 2 : Négliger la conduite du changement

L’automatisation transforme profondément les métiers. Si les collaborateurs ne sont pas formés, accompagnés, rassurés, ils résisteront — consciemment ou non. Et ils ont raison : personne n’adhère à ce qu’il ne comprend pas.

La conduite du changement, c’est :

Erreur 3 : Automatiser sans discernement

Tout n’est pas automatisable de la même manière. La matrice complexité/émotion vue plus haut n’est pas qu’un concept théorique : c’est un outil de décision opérationnel.

Automatiser un sinistre auto avec blessure corporelle de la même manière qu’un bris de glace, c’est prendre un risque majeur sur la satisfaction client et sur la réputation.

L’automatisation transforme les métiers en profondeur.

Le modèle Centaure (IA + Humain) libère les collaborateurs des tâches administratives pour les recentrer sur l’expertise et la relation client.

Trois bénéfices :

Trois erreurs à éviter : croire que la technologie suffit, négliger la conduite du changement, automatiser sans discernement.

Au terme de ce parcours, une chose est claire : la question n’est plus « faut-il automatiser ? » mais « comment automatiser intelligemment ?«

Les technologies sont là. Le cadre réglementaire est posé. Les principes comportementaux sont documentés.

Ce qui fait la différence entre succès et échec ? Trois éléments :

Dans l’assurance de demain, le luxe ne sera ni la rapidité absolue ni l’automatisation maximale. Ce sera la justesse : être aidé par une machine quand c’est efficace, être accompagné par un humain expert quand c’est nécessaire.

Entre ces deux extrêmes, tout est affaire de design. Un design qui respecte la loi, s’appuie sur la science, et place l’humain — assuré et collaborateur — au centre.

C’est cela, automatiser sans déshumaniser.

Bain & Company (2023)

« Customer Experience in Insurance: The Critical Role of Claims »

https://www.bain.com/insights/topics/customer-experience/

Capgemini (2024)

« World Insurance Report 2024 »

https://www.capgemini.com/insights/research-library/world-insurance-report/

Deloitte (2024)

« Insurance Industry Outlook »

https://www2.deloitte.com/us/en/pages/financial-services/articles/insurance-industry-outlook.html

Forrester Research (2023)

« The State of Customer Experience in Insurance »

https://www.forrester.com/research/

Insurance Nexus (2024)

« Claims Processing Benchmark Study »

https://www.insurancenexus.com/research/

AGIRA (2024)

Rapport annuel sur la fraude à l’assurance

https://www.agira.asso.fr/

Johnson, E. J., & Goldstein, D. G. (2003)

« Do Defaults Save Lives? »

Science, 302(5649), 1338-1339.

https://doi.org/10.1126/science.1091721

Moravec, H. (1988)

« Mind Children: The Future of Robot and Human Intelligence »

Harvard University Press

Règlement (UE) 2024/1689 (AI Act)

https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX:32024R1689

Règlement (UE) 2016/679 (RGPD) – Article 22

https://eur-lex.europa.eu/eli/reg/2016/679/oj

Contactez nos experts pour un diagnostic personnalisé de vos parcours

Rejoignez les leaders qui font confiance à notre expertise multilingue et technologique.